人工智慧又有新技能了!這回的新身分是專業編舞家!讓它為你編舞吧!

上篇請看此連結

人工智慧編舞一把罩:FACT 模型

Google 運用上述的 AIST 資料庫,培訓 FACT 模型由音樂生成 3D 舞蹈。這個模型先用動作轉換器和音頻轉換器,分別對一段音樂和一個短的(2 秒)種子動作(seed motion)進行編碼。之後再將嵌入碼連接、發送到跨模型轉換器,該轉換器學習兩種模型之間的對應關係,並生成 N 個未來的動作序列。

然後使用這些序列以自我監督的方式訓練模型。在測試時,Google 將此模型用於自回歸框架,其中所預測的動作則作為下一個生成步驟的輸入。因此,FACT 模型能夠一個框架接著一個框架地,生成長時間的舞蹈動作。

Google 用三指標評估 FACT 的性能

Google 依據以下所述之三個指標,評估人工智慧 FACT 的性能:

動作品質:我們計算 AIST++ 資料庫中的「真實舞蹈動作序列」與 40 個「模型生成的動作序列」之間的 Frechet 起始距離(FID),每個序列具有 1200 幀鏡頭(20 秒)。我們將基於幾何和動力學特徵的 FID 分別表示為 FIDg 和 FIDk。

生成多樣性:與之前的工作(指「深度慣性姿勢捕捉」:從少許的慣性量測中學習而重建人體姿勢)類似:Google 從 AIST++ 測試集中的 40 個「模型生成動作特徵空間」中,計算平均歐氏距離,用以評估模型生成各式舞蹈動作的能力。,接著再比較幾何特徵空間 (Dist g ) 和動力學特徵空間 (Dist k )。

Google 使用不同的音樂,來生成四個不同的編舞版本:Break、Ballet Jazz、Krump 和 Middle Hip-hop(右),但有兩秒是相同的 Hip-hop 舞蹈動作(左),這些相同的動作被稱為「種子動作」。|圖片出處:Google AI Blog

運動-音樂相關:由於沒有合適的指標來衡量輸入音樂(音樂節拍)與所生成的 3D 動作(動作節拍)之間的相關性。所以 Google 提出了一種新的「節拍對齊分數 (BeatAlign)」作為指標。

上圖中顯示 FACT 所生成的舞蹈動作的動作速率(藍色曲線)、動作節拍(綠色虛線),及音樂節拍(橙色虛線)。通過從動作速率曲線中找到局部最小值,來提升動作節拍。|圖片出處:Google AI Blog

下篇請看此連結

相關文章:

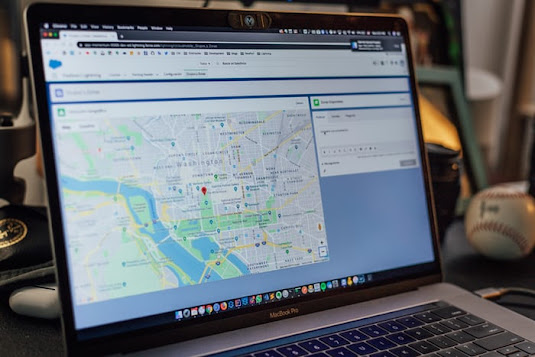

油價漲免驚!Google Maps 用人工智慧規劃「最省油路線」

人類又輸了?工程師需花數月設計出IC晶片,AI六小時就搞定!

人工智慧幫你診斷皮膚疾病!Google AI鏡頭變身皮膚科幫手

生物學最大謎團被人工智慧 破解!DeepMind 攻克「蛋白質折疊」奧秘